|

КОНТАКТЫ |

|

| |

Тел. (391) 290 44 77

E-mail: sales@vsemcomp.ru

Пишите нам Телеграмм

г.Красноярск, ул.Мечникова, д.44А, оф.139

Работаем с 10:00 до 19:00

Выдача товара с с 12:00 до 17:00

Выходной: сб, вс |

|

|

Архитектура EMC VNX

Из всей линейки стоит выделить VNX 5100, он достаточно "куцый". Массив не поддерживает файловый доступ, ряд фирменных технологий EMC (например FAST VP, но FAST Cashe поддерживается), на данный момент нет плат Flex I/O с поддержкой iSCSI, количество поддерживаемых дисков - всего 75. И все это немалые недостатки данной системы, но стоит взглянуть с другой стороны. Позиционируется 5100 как замена серии EMC AX!, высокопроизводительная и функциональная замена, но AX, а не как думают многие CX. В AX никогда не было поддержки Flex I/O, FAST, диски подключались по SAS 1.0 и количество этих самых дисков было всего 60. Не говоря уже про обрезанную версию Navisphere.

Если смотреть с этой точки зрения, то VNX 5100 - это шаг вперед. Как с точки зрения повышения производительности, так и функциональности. Есть еще один плюс, полки для AX и CX разные (и не удивительно SAS и FC подключение дисков), то есть если компания вырастет и ей понадобится более производительный массив, то придется покупать НОВУЮ СХД. А как многие знают, основная цена массива нередко находится именно в дисках ("Голова" 5100 стоит всего около 10 000уе в конечных ценах). Сейчас же есть возможность купить 5100, докупать к нему диски, а когда понадобится бОльшая производительность или функционал купить "голову" от VNX 5300 и произвести апгрейд. А если в вашем регионе есть Trade-in, то цена апгрейда может вообще оказаться мизерной.

Ну да ладно, перейдем к Unified архитектуре VNX:

Отмечаем, что есть разные протоколы блоки - FC, FCoE, iSCSI, файлы - NFS, pNFS, CIFS, MPFS и объекты - REST и SOAP. Раньше за объекты отвечал отдельный продукт - EMC Atmos, теперь часть функционала внедрено и в VNX. Еще стоит отметить протокол - MPFS - это протокол разработанный EMC, он имеет гораздо меньший overhead, чем NFS и позволяет передавать файлы по сети SAN!

Архитектура VNX, но теперь в физическом, а не логическом исполнении:

5100 - только блочное устройство. В 5300 и 5500 для получения только блочного доступа необходимо использовать DPE (Процессорный модуль. В отличии от Clariion содержит диски) и SPS (источник(и) бесперебойного питания, который позволяет скинуть содержимое кеша на диски). В 5700 и 7500 вместо DPE используется связка из DAE (дисковой полки) и SPE, процессорного модуля без дисков. Так же, чем старше модель, тем мощнее процессоры. Например, VNX 5100 использует процессоры 1,6ГГц с двумя ядрами, а 5300 процессоры той же частоты, но уже с 4-мя ядрами.

Если нужен файловый доступ, то необходимо добавить DME (Data Mover Enclousure) и Control Starion. DME используется для доступа к файлам и объектам, по сути это сервер x86 архитектуры, но в исполнении EMC. Содержит модули Flex I/O для добавления дополнительных интерфейсов.

Control Starion - это сервер управления, применяется в случае файлового доступа. Представляет из себя обычный сервер x86 архитектуры с установленным Linux. Может быть установлена одна станция управления или 2 для избыточности. В случае выхода из строя CS, система не прекращает отдавать данные, но не доступно управление файловым доступом.

Многие ругают EMC за использование "раздельной" архитектуры. Действительно не очень удобно использовать отдельные сервера для блоков, еще и какой то Control Starion. Гораздо проще все объединить в одной системе, как в VNXe. Но задумайтесь какую это сулит производительность и масштабируемость. Вы купили 7500 и вам не нужен файловый доступ? Не вопрос, покупайте Block Only, который занимает всего 5U с 25 дисками. Нужен доступ к файлам? Окей, еще плюс 3U для CS и DME. Мало производительности файловой части? Ну хорошо, еще плюс 2U для новых DME. Это очень гибко! Ну и 48 процессорных ядер для обработки файлов и объектов - немало!

DPE в 5100, 5300 и 5500 спереди выглядит как полка с дисками. Только первые 4 диска отмечены желтой ленточкой - это операционная система массива - FLARE. Диски для неё называются - Vault. Стоит отметить, что не все пространство с этих дисков используется под ОС, "откусывается" 192ГБ с этих дисков. Остальное пространство вы можете использовать. Часто приходится натыкаться на споры относительно этих дисков и лично я считаю Vault недостатком, особенно для небольших систем. Но так уж сложилось, нужно просто помнить об этих дисках и планировать систему с их учетом. Мы нередко рекомендуем заказчикам устанавливать Vault диски SATA, на них можно хранить бэкапы или темплейты виртуальных машин, так тоже можно, но не все этим пользуются.

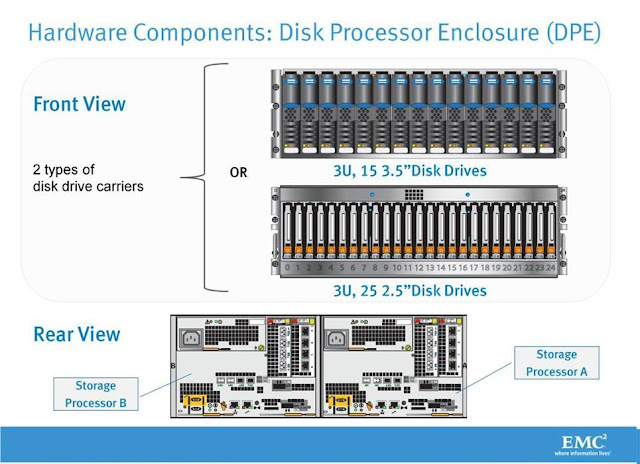

DPE может комплектоваться 3.5 дюймовыми дисками, тогда их влазит 15 штук, и 2.5 дюймовыми - 25 штук. В обоих случаях DPE занимает 3U.

На задней панели каждого контроллера можно найти: 2 разъёма DB 9 (кабель для COM порта в комплекте) - один для подключения бесперебойника, второй для траблшутинга. 2 разъёма RJ-45 для управления блочным доступом. 4-ре порта FC, в случае файлового доступа часть из них будут подключены к Data Movers. Порты SAS для подключения полок. Порты Flex I/O для подключения плат расширения блочного доступа, не поддерживаются для VNX 5100. Платы расширения файлов устанавливаются в Data Mover.

У 5500 и 5700 модуль управления выглядит как показано ниже. Обратите внимание, на схожесть SPE и DME.

Собственно Data Mover:

Data Mover выполнен в том же корпусе, что процессорный модуль VNX (SPE) и процессорные модули Clariion или Celerra, унификация на лицо. В каждом DME (SPE) установлено 2 Data Mover и 4-ре блока питания. Блоки питания запитаны от разных входов - 1 и 3 от одного, 2 и 4 от другого, следовательно при отключении питания от одного из входов оба DM (SP) будут работать каждый от своего БП. Если достать 2 блока питания, то удастся извлечь сам контроллер и получить доступ к памяти.

Если взглянуть сзади на DME, то видно (x-Blade B, слева на право): модуль управления, коммутируется на CS, модуль для подключения DME к DPE или SPE, модули расширения для блочного устройства.

Платы Ultra - Flex I/O:

Ну и последний этап - дисковые полки. Они бывают для дисков 2.5 дюймов высотой 2U, и 3.5 дюймов 3U. Вмещают соответственно 25 и 15 дисков. Диски 15к RPM, SATA и SSD бывают только 3.5 дюйма.

Фото 2.5:

3.5:

Вы наверное заметили карту LCC в полках. Эти платы отвечают за коммутацию полок с процессорными модулями, подключение к каждой плате LCC происходит 2-мя SAS кабелями, один кабель идет к предыдущей полке или процессорному модулю, второй кабель к следующей полке. В выключенном состоянии (нет питания к полке) LCC производит "сквозное" подключение полок, то есть есть полки 1-2-3, мы отключили полностью! питание от 2, полки 1 и 3 видят друг друга.

Полки 3.5 и 2.5 могут быть перемешаны в системе как угодно.

С точки зрения "железа" пожалуй все. Стоит еще посвятить статью функционалу массивов EMC, так как системы хранения уже давно перестали быть большими коробками с дисками.

Источник: http://vhardware.com.ua/2011/09/emc-vnx.html

назад

|